GPT-5.3-Codex-Spark – ein superschnelles Modell von OpenAI und Cerebras

16:33, 13.02.2026

OpenAI hat mit GPT-5.3-Codex-Spark eine spezialisierte Version für extrem schnelle Codegenerierung veröffentlicht. Diese Neuheit zeichnet sich durch eine unglaubliche Geschwindigkeit aus: Das Modell kann mehr als 1000 Token pro Sekunde ausgeben.

Leistung von Spark

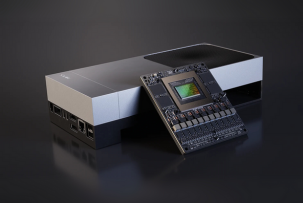

Die Leistung von Spark wurde durch den Verzicht auf herkömmliche GPUs zugunsten spezialisierter Cerebras Wafer Scale Engine 3-Chips ermöglicht. Dank der neuen Architektur und einer permanenten WebSocket-Verbindung konnte die Latenz bei der Token-Ausgabe um 80 % reduziert werden.

Dieser Release ist das erste Ergebnis der Zusammenarbeit zwischen OpenAI und Cerebras. Dennoch handelt es sich um eine Version von GPT-5.3-Codex und nicht um ein komplett neues Modell. Spark wurde mit Fokus auf Echtzeit-Coding entwickelt und bietet daher punktuelle Korrekturen und Code-Anpassungen 15-mal schneller als herkömmliche Modelle.

Benchmarks

Die phänomenale Geschwindigkeit wird durch eine geringere Genauigkeit der Antworten ausgeglichen.

SWE-Bench Pro zeigt, dass Spark eine Anfrage in 2–3 Minuten mit einem Ergebnis von 52 % bearbeitet, während das größere Modell 57 % erreicht, dafür aber 16 Minuten benötigt.

Terminal-Bench 2.0 zeigt eine Genauigkeit von 58,4 % für Spark gegenüber 77,3 % beim Flaggschiff.

Dennoch übertrifft Spark das Mini-Modell GPT-5.1-Codex-mini deutlich. Cerebras geht davon aus, dass das neue Modell eine sofortige Antwortzeit zum neuen Industriestandard machen könnte.

Wie kann man Spark testen?

Derzeit befindet sich das Modell in der Research-Preview-Phase und ist für ChatGPT-Pro-Abonnenten über CLI, eine VS Code-Erweiterung und die Codex-App verfügbar. Das Modell unterstützt keine Bilder, und APIs sind nur für einen engen Kreis von Partnern zugänglich.